本文针对Linux服务器网络丢包的复杂故障场景,提供从物理网卡到应用服务的全链路诊断方案。通过ethtool、tcpdump、dropwatch等工具的组合使用,系统化分析丢包根因,涵盖硬件故障、驱动异常、内核参数不当、应用层配置错误等典型问题,并提供完整的性能优化和预防措施。

![图片[1]-Linux网络丢包故障排查:从网卡到应用的全链路诊断](https://blogimg.vcvcc.cc/2025/11/20251109053116790-1024x576.png?imageView2/0/format/webp/q/75)

一、网络丢包故障的快速定位

1. 基础连通性检查

建立系统化的网络健康检查流程:

<strong>#!/bin/bash</strong>

# network_health_check.sh - 网络基础健康检查

echo "=== 网络基础健康检查 ==="

echo "检查时间: $(date)"

# 1. 网络接口状态检查

echo -e "\n1. 网络接口状态:"

ip -br addr show | grep -v "LOOPBACK"

# 2. 路由表检查

echo -e "\n2. 路由表信息:"

ip route show

# 3. 邻居表检查

echo -e "\n3. ARP/NDP表状态:"

ip neigh show

# 4. 基础连通性测试

echo -e "\n4. 网络连通性测试:"

ping -c 3 8.8.8.8 | grep -E "packet loss|rtt"

# 5. DNS解析检查

echo -e "\n5. DNS解析测试:"

nslookup google.com <strong>2</strong>>/dev/null | grep -A1 "Name:"

# 6. 端口监听检查

echo -e "\n6. 关键端口监听状态:"

netstat -tunlp | grep -E ":(80|443|22)\s"2. 实时丢包监控告警

建立持续的丢包监控机制:

<strong>#!/bin/bash</strong>

# packet_loss_monitor.sh - 实时丢包监控

INTERFACE="eth0"

THRESHOLD=1 # 丢包率阈值%

monitor_packet_loss() {

while true; do

# 获取接收丢包统计

rx_dropped=$(cat /sys/class/net/$INTERFACE/statistics/rx_dropped)

rx_packets=$(cat /sys/class/net/$INTERFACE/statistics/rx_packets)

# 计算丢包率

if [ $rx_packets -ne 0 ]; then

loss_rate=$(echo "scale=4; $rx_dropped * 100 / $rx_packets" | bc)

if [ $(echo "$loss_rate >= $THRESHOLD" | bc) -eq 1 ]; then

echo "[警告] 接口 $INTERFACE 丢包率: ${loss_rate}%"

echo "详细统计:"

ethtool -S $INTERFACE | grep -E "drop|error" | head -10

fi

fi

sleep 5

done

}

# 启动监控

monitor_packet_loss二、物理层与数据链路层诊断

1. 网卡硬件状态检查

使用ethtool进行物理层深度诊断:

<strong>#!/bin/bash</strong>

# nic_diagnosis.sh - 网卡深度诊断

INTERFACE=${1:-eth0}

echo "=== 网卡 $INTERFACE 深度诊断 ==="

# 1. 驱动程序信息

echo -e "\n1. 驱动信息:"

ethtool -i $INTERFACE

# 2. 网卡统计信息

echo -e "\n2. 详细统计信息:"

ethtool -S $INTERFACE | grep -E "err|drop|fail|discard" | head -20

# 3. 网卡能力检查

echo -e "\n3. 支持的功能:"

ethtool -k $INTERFACE | grep -E "on|off"

# 4. 环缓冲区设置

echo -e "\n4. 环缓冲区配置:"

ethtool -g $INTERFACE

# 5. 物理连接状态

echo -e "\n5. 物理连接信息:"

ethtool $INTERFACE

# 6. EEPROM信息(需要权限)

echo -e "\n6. EEPROM信息:"

ethtool -e $INTERFACE <strong>2</strong>>/dev/null | head -5 || echo "需要root权限"

# 7. 中断统计

echo -e "\n7. 中断分布:"

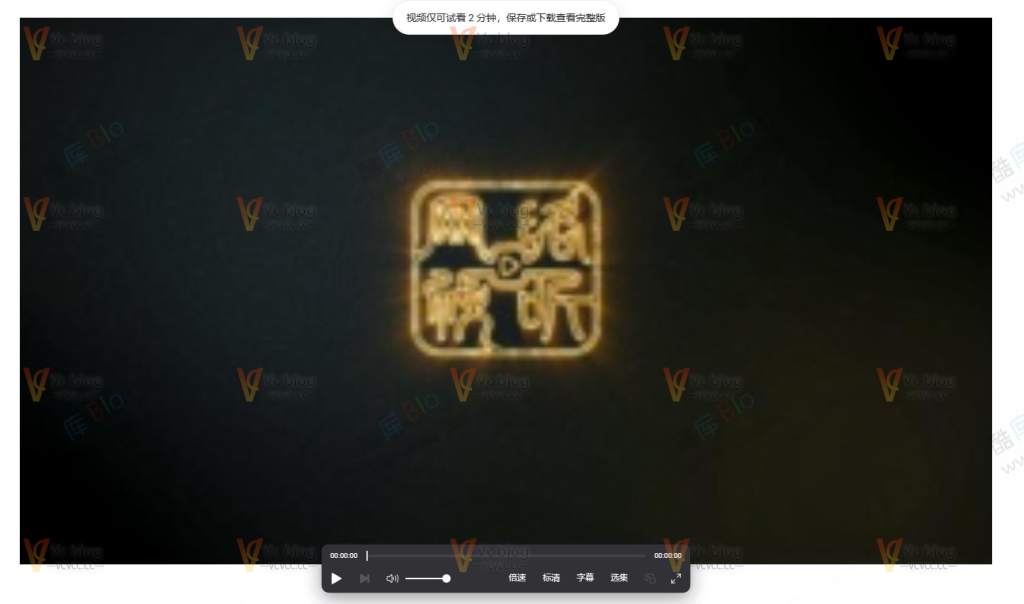

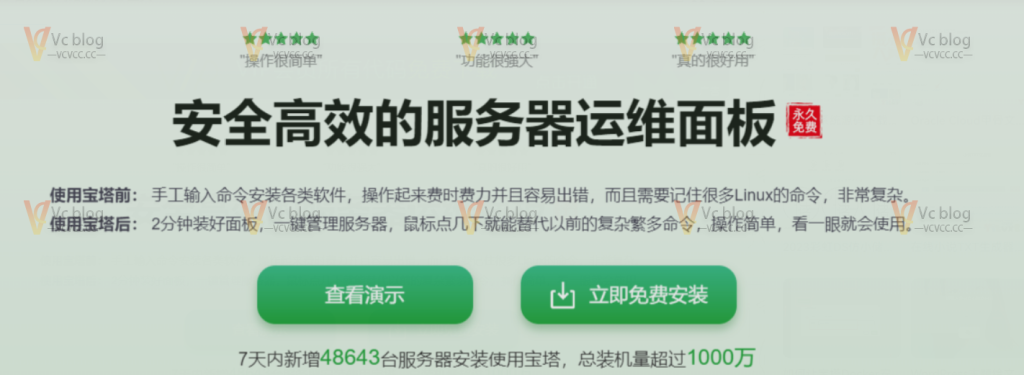

cat /proc/interrupts | grep $INTERFACE2. 常见物理层问题排查表

![图片[2]-Linux网络丢包故障排查:从网卡到应用的全链路诊断](https://blogimg.vcvcc.cc/2025/11/20251109061459774.png?imageView2/0/format/webp/q/75)

三、网络层与传输层深度分析

1. TCP连接状态诊断

分析TCP层面的丢包和重传问题:

<strong>#!/bin/bash</strong>

# tcp_connection_analysis.sh - TCP连接深度分析

echo "=== TCP连接状态分析 ==="

# 1. TCP连接统计

echo -e "\n1. TCP连接状态统计:"

ss -ant | awk 'NR>1 {print $1}' | sort | uniq -c | sort -rn

# 2. TCP重传统计

echo -e "\n2. TCP重传统计:"

cat /proc/net/snmp | grep -A1 Tcp | grep -v Tcp

# 3. 缓冲区使用情况

echo -e "\n3. TCP缓冲区使用:"

cat /proc/sys/net/ipv4/tcp_mem

cat /proc/sys/net/ipv4/tcp_rmem

cat /proc/sys/net/ipv4/tcp_wmem

# 4. 连接跟踪表

echo -e "\n4. 连接跟踪表状态:"

cat /proc/sys/net/netfilter/nf_conntrack_count <strong>2</strong>>/dev/null || echo "连接跟踪未启用"

# 5. 详细TCP指标

echo -e "\n5. 详细TCP指标:"

for metric in ListenOverflows ListenDrops PassiveOpens ActiveOpens; do

value=$(grep $metric /proc/net/netstat | awk '{print $2}')

echo "$metric: $value"

done2. 内核丢包点定位

使用dropwatch定位内核丢包点:

<strong>#!/bin/bash</strong>

# kernel_drop_analysis.sh - 内核丢包点分析

echo "=== 内核丢包点分析 ==="

# 安装dropwatch(如需要)

if ! command -v dropwatch > /dev/null; then

echo "安装dropwatch..."

if [ -f /etc/redhat-release ]; then

yum install -y dropwatch

else

apt-get update && apt-get install -y dropwatch

fi

fi

# 启动dropwatch进行实时监控

echo "启动dropwatch监控(需要root权限)..."

echo "按Ctrl+C停止监控"

timeout 30 dropwatch -l kas > /tmp/dropwatch.log <strong>2</strong>><strong>&1</strong> &

# 同时进行网络压力测试

echo "进行网络压力测试..."

ping -f -c 1000 8.8.8.8 > /dev/null <strong>2</strong>><strong>&1</strong>

# 分析结果

echo -e "\n丢包点分析结果:"

cat /tmp/dropwatch.log | grep -v "bytes" | head -20四、应用层网络问题诊断

1. 应用连接池诊断

分析应用层的连接管理问题:

#!/usr/bin/env python3

"""

应用连接池诊断工具

检测连接泄漏、连接池满等常见问题

"""

import subprocess

import re

from collections import defaultdict

class ConnectionPoolAnalyzer:

def __init__(self, app_pid):

self.app_pid = app_pid

self.connections = defaultdict(list)

def analyze_established_connections(self):

"""分析已建立的连接"""

print("=== 应用连接状态分析 ===")

# 获取应用的所有TCP连接

cmd = f"ss -tpan | grep 'pid={self.app_pid}'"

result = subprocess.run(cmd, shell=True, capture_output=True, text=True)

connections_by_remote = defaultdict(int)

for line in result.stdout.split('\n'):

if not line.strip():

continue

# 解析连接信息

parts = line.split()

if len(parts) >= 5:

state = parts[1]

remote_addr = parts[4]

if state == 'ESTAB':

connections_by_remote[remote_addr] += 1

# 输出连接统计

print(f"总ESTABLISHED连接数: {sum(connections_by_remote.values())}")

print("\n按远程地址统计:")

for addr, count in sorted(connections_by_remote.items(),

key=lambda x: x[1], reverse=True)[:10]:

print(f" {addr}: {count} 个连接")

def check_connection_leaks(self, duration=60):

"""检测连接泄漏"""

print(f"\n=== 连接泄漏检测(持续{duration}秒)===")

initial_cmd = f"ss -tpan | grep 'pid={self.app_pid}' | grep ESTAB | wc -l"

initial_count = int(subprocess.run(initial_cmd, shell=True,

capture_output=True, text=True).stdout.strip())

print(f"初始连接数: {initial_count}")

print("模拟业务操作...")

# 这里可以触发一些业务操作

import time

time.sleep(duration)

final_count = int(subprocess.run(initial_cmd, shell=True,

capture_output=True, text=True).stdout.strip())

print(f"最终连接数: {final_count}")

if final_count > initial_count * 1.2: # 20%增长阈值

print("⚠️ 检测到可能的连接泄漏!")

return True

else:

print("✅ 连接数正常")

return False

if __name__ == "__main__":

import sys

if len(sys.argv) != 2:

print("用法: python3 connection_analyzer.py <应用PID>")

sys.exit(1)

analyzer = ConnectionPoolAnalyzer(sys.argv[1])

analyzer.analyze_established_connections()

analyzer.check_connection_leaks(30)2. 应用层网络超时分析

诊断应用层网络超时问题:

<strong>#!/bin/bash</strong>

# application_timeout_analysis.sh - 应用超时分析

echo "=== 应用网络超时分析 ==="

# 1. 检查DNS解析时间

echo -e "\n1. DNS解析时间测试:"

time nslookup google.com > /dev/null <strong>2</strong>><strong>&1</strong>

time nslookup google.com > /dev/null <strong>2</strong>><strong>&1</strong> # 第二次测试缓存效果

# 2. TCP连接建立时间

echo -e "\n2. TCP连接建立时间:"

time timeout 5 nc -zv google.com 80 <strong>2</strong>><strong>&1</strong> | grep "succeeded"

# 3. HTTP响应时间测试

echo -e "\n3. HTTP响应时间:"

if command -v curl > /dev/null; then

curl -w "

域名解析: %{time_namelookup}

建立连接: %{time_connect}

SSL握手: %{time_appconnect}

开始传输: %{time_pretransfer}

首字节: %{time_starttransfer}

总时间: %{time_total}

" -o /dev/null -s "https://www.google.com"

fi

# 4. 应用超时配置检查

echo -e "\n4. 常见应用超时配置:"

for app in nginx apache2 mysql redis; do

if systemctl is-active --quiet $app <strong>2</strong>>/dev/null; then

echo "检查 $app 配置..."

case $app in

nginx)

grep -r "timeout" /etc/nginx/ | grep -v "#" | head -5

;;

mysql)

mysql -e "SHOW VARIABLES LIKE '%timeout%';" <strong>2</strong>>/dev/null || echo "无法连接MySQL"

;;

esac

fi

done五、内核参数调优与优化

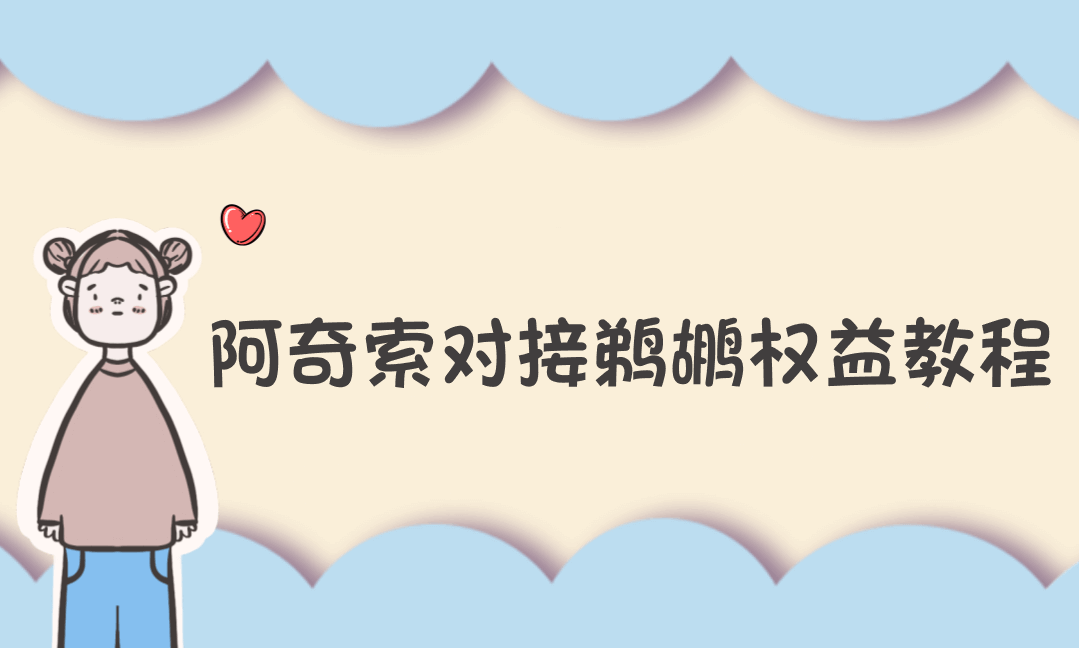

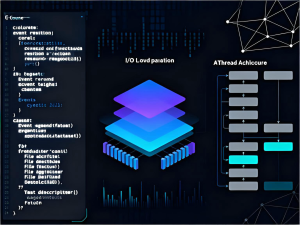

1. 网络内核参数优化表

![图片[3]-Linux网络丢包故障排查:从网卡到应用的全链路诊断](https://blogimg.vcvcc.cc/2025/11/20251109061521406.png?imageView2/0/format/webp/q/75)

2. 优化脚本实施

<strong>#!/bin/bash</strong>

# network_optimization.sh - 网络内核参数优化

echo "=== 网络内核参数优化 ==="

# 备份当前配置

BACKUP_FILE="/tmp/sysctl_backup_$(date +%Y%m%d_%H%M%S).conf"

sysctl -a | grep -E "^(net\.|net\.ipv4\.)" > $BACKUP_FILE

echo "当前配置已备份到: $BACKUP_FILE"

# 应用优化参数

cat > /tmp/network_optimization.conf << 'EOF'

# 网络核心参数

net.core.rmem_max = 33554432

net.core.wmem_max = 33554432

net.core.netdev_max_backlog = 30000

net.core.somaxconn = 1024

net.core.optmem_max = 65536

# TCP内存设置

net.ipv4.tcp_rmem = 4096 87380 33554432

net.ipv4.tcp_wmem = 4096 16384 33554432

net.ipv4.tcp_mem = 786432 1048576 1572864

# TCP连接设置

net.ipv4.tcp_max_syn_backlog = 2048

net.ipv4.tcp_syncookies = 1

net.ipv4.tcp_fin_timeout = 30

net.ipv4.tcp_keepalive_time = 600

net.ipv4.tcp_keepalive_probes = 5

net.ipv4.tcp_keepalive_intvl = 15

# TCP快速打开

net.ipv4.tcp_fastopen = 3

# 连接跟踪

net.netfilter.nf_conntrack_max = 262144

net.netfilter.nf_conntrack_tcp_timeout_established = 86400

EOF

# 应用优化

sysctl -p /tmp/network_optimization.conf

echo "网络参数优化完成"

echo "建议重启网络服务: systemctl restart network"六、高级诊断工具与技术

1. eBPF网络流量分析

使用eBPF进行深度网络诊断:

/**

* eBPF网络丢包分析程序

* 需要: BCC框架, Linux 4.4+

*/

#include <uapi/linux/ptrace.h>

#include <net/sock.h>

#include <bcc/proto.h>

// 丢包事件结构

struct drop_event_t {

u32 pid;

u32 cpu;

char comm[TASK_COMM_LEN];

u64 stack_id;

u64 timestamp;

};

// 性能事件映射

BPF_PERF_OUTPUT(drop_events);

BPF_STACK_TRACE(stack_traces, 128);

// kfree_skb跟踪点

TRACEPOINT_PROBE(skb, kfree_skb) {

struct drop_event_t event = {};

event.pid = bpf_get_current_pid_tgid() >> 32;

event.cpu = bpf_get_smp_processor_id();

event.timestamp = bpf_ktime_get_ns();

event.stack_id = stack_traces.get_stackid(args, 0);

bpf_get_current_comm(&event.comm, sizeof(event.comm));

// 提交丢包事件

drop_events.perf_submit(args, &event, sizeof(event));

return 0;

}

// 网络设备丢包统计

BPF_HASH(dev_drops, u32, u64);

int trace_net_dev_queue(struct pt_regs *ctx, struct sk_buff *skb) {

u32 ifindex = skb->dev->ifindex;

u64 *count = dev_drops.lookup_or_init(&ifindex, &zero);

if (count) {

(*count)++;

}

return 0;

}2. 系统性能关联分析

建立网络与系统资源的关联分析:

<strong>#!/bin/bash</strong>

# system_network_correlation.sh - 系统与网络关联分析

echo "=== 系统资源与网络性能关联分析 ==="

# 同时收集多个维度的指标

collect_metrics() {

# CPU使用率

cpu_usage=$(top -bn1 | grep "Cpu(s)" | awk '{print $2}' | cut -d'%' -f1)

# 内存使用

mem_usage=$(free | grep Mem | awk '{printf "%.2f", $3/\ * 100.0}')

# 网络丢包率

interface="eth0"

rx_packets=$(cat /sys/class/net/$interface/statistics/rx_packets)

rx_dropped=$(cat /sys/class/net/$interface/statistics/rx_dropped)

if [ $rx_packets -gt 0 ]; then

drop_rate=$(echo "scale=4; $rx_dropped * 100 / $rx_packets" | bc)

else

drop_rate=0

fi

# TCP重传率

tcp_retrans=$(cat /proc/net/snmp | grep Tcp | tail -1 | awk '{print $13}')

tcp_segs_out=$(cat /proc/net/snmp | grep Tcp | tail -1 | awk '{print $12}')

if [ $tcp_segs_out -gt 0 ]; then

retrans_rate=$(echo "scale=4; $tcp_retrans * 100 / $tcp_segs_out" | bc)

else

retrans_rate=0

fi

# 输出时间序列数据

timestamp=$(date +%s)

echo "$timestamp,$cpu_usage,$mem_usage,$drop_rate,$retrans_rate"

}

# 创建CSV文件头

echo "timestamp,cpu_usage,mem_usage,drop_rate,retrans_rate" > /tmp/network_correlation.csv

# 持续收集数据

echo "开始收集系统与网络关联数据(Ctrl+C停止)..."

while true; do

collect_metrics >> /tmp/network_correlation.csv

sleep 5

done七、典型案例分析

1. 案例一:网卡多队列配置不当

问题现象:万兆网卡在高压下出现大量丢包,但CPU使用率不高

排查过程:

# 检查中断分布

cat /proc/interrupts | grep eth0

# 检查多队列配置

ethtool -l eth0

# 检查RPS配置

cat /sys/class/net/eth0/queues/rx-*/rps_cpus解决方案:

# 启用多队列

ethtool -L eth0 combined 8

# 配置RPS

echo ffff > /sys/class/net/eth0/queues/rx-0/rps_cpus

# 调整缓冲区

ethtool -G eth0 rx 4096 tx 40962. 案例二:TCP缓冲区不足导致性能下降

问题现象:大文件传输速度慢,TCP重传率高

排查过程:

# 检查TCP缓冲区使用

cat /proc/sys/net/ipv4/tcp_rmem

cat /proc/sys/net/ipv4/tcp_wmem

# 监控socket缓冲区

ss -tem

# 检查应用程序缓冲区设置

netstat -tn | grep ESTAB | awk '{print $1}' | xargs -I {} cat /proc/{}/net/sockstat解决方案:

# 调整内核参数

echo 'net.core.rmem_max = 33554432' >> /etc/sysctl.conf

echo 'net.core.wmem_max = 33554432' >> /etc/sysctl.conf

echo 'net.ipv4.tcp_rmem = 4096 87380 33554432' >> /etc/sysctl.conf

echo 'net.ipv4.tcp_wmem = 4096 16384 33554432' >> /etc/sysctl.conf

# 应用配置

sysctl -p总结

Linux网络丢包故障排查需要系统化的方法和专业的工具链:

排查方法论:

- 分层诊断:从物理层到应用层逐层排查

- 工具组合:ethtool、tcpdump、dropwatch、eBPF等工具协同使用

- 性能基线:建立正常的性能基线用于对比分析

- 监控预警:建立持续的监控和告警机制

关键优化点:

- 网卡多队列和中断均衡配置

- TCP缓冲区大小调优

- 内核参数系统性优化

- 应用层连接池合理配置

预防措施:

- 定期进行网络健康检查

- 建立性能基线监控

- 实施灰度发布和压力测试

- 文档化故障处理流程

通过系统化的排查方法和预防措施,可以有效解决Linux网络丢包问题,并建立长效的网络健康保障机制。

© 版权声明

THE END

暂无评论内容